- Dr. Joachim Haenicke

- Dr. Jan Sölter

- Dr. Thomas Rost

- Jan Neukirchen

- Dr. Tabea Golgath

- Neuronale Netzwerke

- Maschinelles Lernen

- Kreativität

- Künstliche Intelligenz

- KI

- KI Schule

- LINK Niedersachsen

- Informatik

Lerneinheit 6:

Textdaten – Wortvektoren

- Word2Vec: Numerische Repräsentation von Wörtern und Wortvektorähnlichkeiten

Die Nachteile von Verfahren wie TFIDF liegen auf der Hand: Eine simple Häufigkeitsanalyse von Wörtern in Texten bildet die vielen kontextabhängigen Aspekte von Wörtern nicht mit ab.

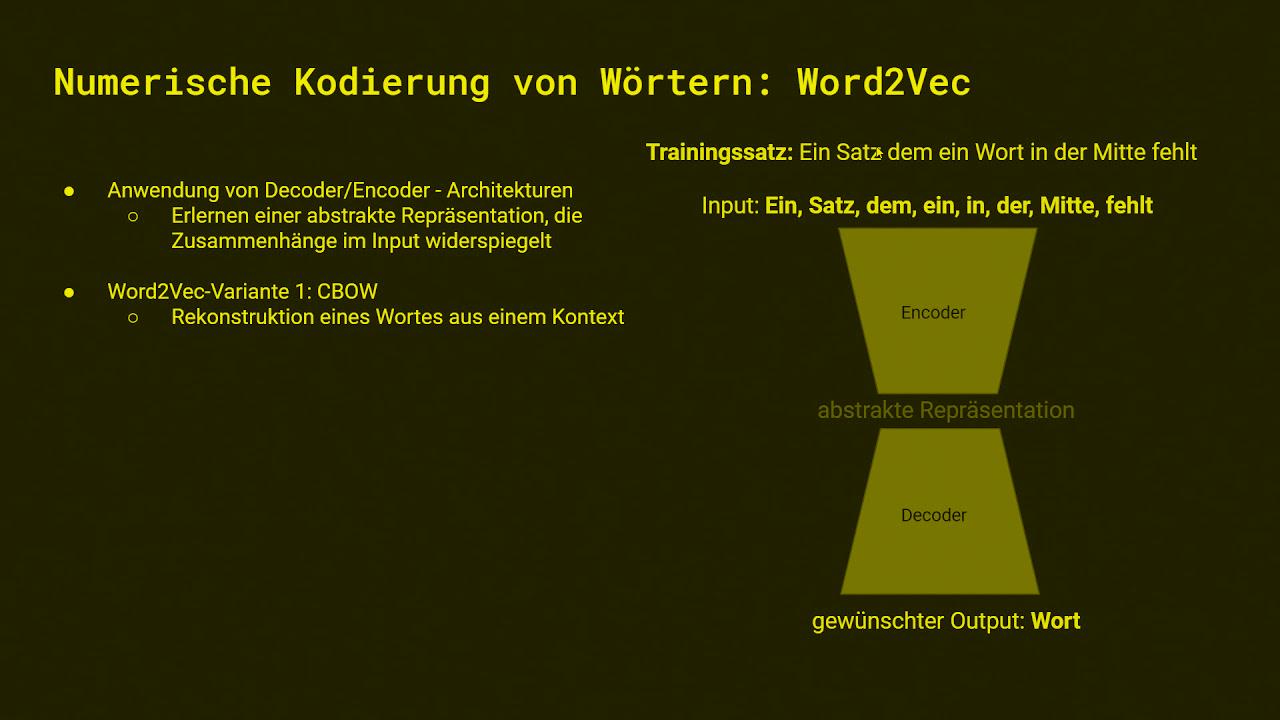

Eine Technik, mit der Kontextabhängigkeit automatisiert erlernt werden kann, nennt sich Word2Vec. Hierbei wird eine Encoder-Decoder-Architektur verwendet, um ähnlich einem Autoencoder eine abstrakte Repräsentation in Form sogenannter Wortvektoren zu erlernen. Dieser komprimierte Code entspricht dem uns bekannten latenten Raum, wird jedoch im Zusammenhang von Word2Vec als Embedding bezeichnet.

Je nach Art des Trainings versucht der Decoder anschließend auf Basis des Embeddings bzw. der Wortvektoren vom Kontext auf einzelne Wörter oder von einzelnen Wörtern auf den Kontext zu schließen. Im Rahmen dieser Lerneinheit werden wir uns bereits

vorgegebene Embeddings anschauen, also ein bereits trainiertes Modell verwenden. Wir zeigen euch, wie ihr anhand von Textdaten ein Word2Vec-Modell tranieren könnt. Abschließend werfen wir einen kleinen Blick auf ein Transformer-Modell, welches auf

Basis von Attention-Modulen wesentlich komplexere kontextabhängige Zusammenhänge abbilden kann als ein Word2Vec-Modell.

Neben der unten verlinkten Programmierübung, könnt ihr hier --> Word2Vec selbst trainieren.

Neben der unten verlinkten Programmierübung, gibt es hier --> mehr Informationen zu Attention und Transformers

Hier könnt ihr euch das Vorlesungsvideo mit Joachim Haenicke (2019/20) anschauen: --> Zum YouTube Video

Alle anderen Kurse der LINK KI-Schule findet ihr -> hier.

Die LINK-KI-Schule wurde entwickelt von Dr. Joachim Haenicke, Dr. Jan Sölter und Dr. Thomas Rost.

Die Google Colab Notebooks wurden von Jan Neukirchen auf Funktionalität und Aktualität der notwendigen Daten überprüft. Die letze Aktualisierung fand im April 2023 statt.